Transhumanismus & Netzphilosophie

Thomas Barth

„Ein Gespenst geht um, nicht nur in Europa – das Gespenst des Transhumanismus. Seine Priester und Auguren haben bereits prominente Forschungslaboratorien, Universitäten, globale Unternehmen und politische Institutionen besetzt.“, warnte 2017 die NZZ und hatte damit nicht ganz unrecht. Einige transhumanistische Stimmen wollen heute offenbar einer hemmungslosen Digitalisierung den mühsam erkämpften Datenschutz aus dem Weg räumen.

Der Biologe und überzeugte Eugeniker Julian Sorell Huxley prägte 1951 den Begriff “Transhumanismus” im Aufsatz New Bottles for New Wine und setzte sich zugleich als erster UNESCO-Generalsekretär und bei der Allgemeinen Erklärung der Menschenrechte für humanistische Werte ein. Julians Bruder Aldous Huxley warnte dagegen schon 1932 in seiner Babies-in-Bottles-Dystopie “Schöne neue Welt” vor einer Zukunft mit biologisch fabrizierter Drei-Klassen-Gesellschaft: Genetische oder technische Intelligenzsteigerung hatte schon immer ihre Fans und gehört heute zu den Hoffnungen der neuen Bewegung.

Viele erinnern sich dabei an die LSD-selige SMILE-Revolution (Space Migration, Intelligence Increasement, Life Extension) des „Exo-Psychologen“ Timothy Leary und sei es nur aus den Pop-Conspiracy-Bestsellern von Robert Anton Wilsons Auge-in-der-Pyramide-Zyklus. Bereits im 19.Jahrhundert brachte Auguste Comte, Begründer von Soziologie und Positivismus, eine vom Fortschritt berauschte Bewegung zusammen, in der man sich z.B. von der Medizin beträchtliche Verlängerungen der Lebenszeit, wenn gar nicht Unsterblichkeit erhoffte.

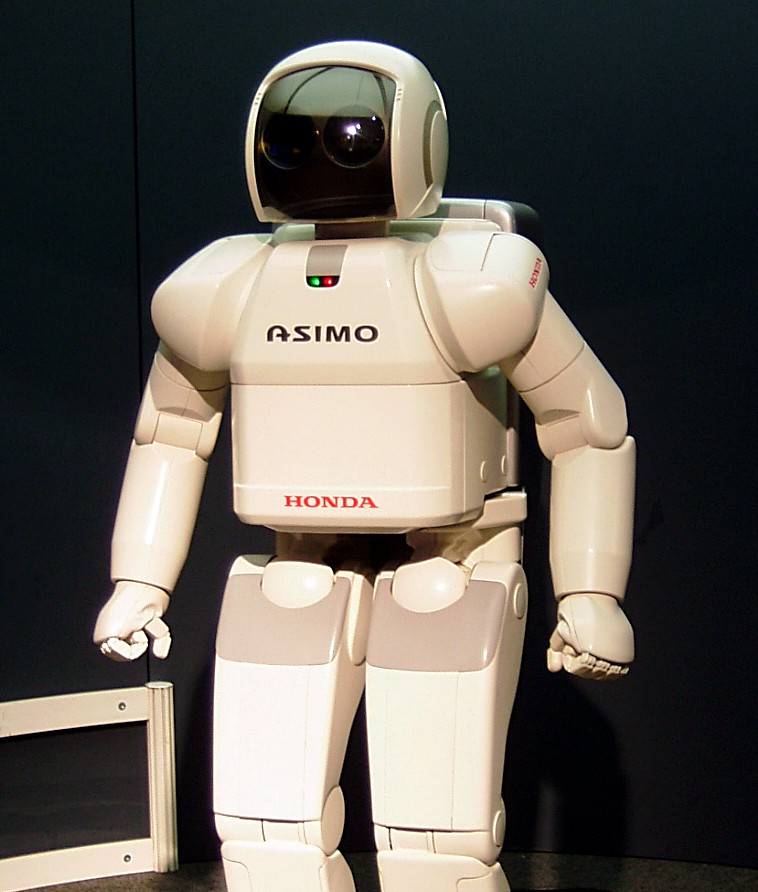

Heute verstehen sich Transhumanisten als Teil einer Bewegung, die vom „Posthumanismus“ abzugrenzen ist, der nicht den Menschen selbst, sondern als eher theoretische Richtung das Menschenbild des Humanismus überwinden will. Dieses wird, anknüpfend etwa an Michel Foucault und andere Postmoderne, mit Schattenseiten der Moderne in Verbindung gebracht: Etwa psychiatrische Entmündigung, Sexismus, Rassismus, Kolonialismus, Totalitarismus usw. Der Transhumanismus reflektiert diese Schattenseiten eher nicht, steht sogar teilweise zu tradierten humanistischen Werten und will sie auf „verbesserte Menschen“ (Enhancement), Cyborgs und Künstliche Intelligenzen ausweiten (Janina Loh 2018).

Wie religiös ist der Transhumanismus?

Die Philosophin und Theologin Anna Puzio legte aus Sicht der philosophischen Anthropologie 2022 eine scharfe Kritik des Transhumanismus (TH) vor und fragt: Wie verändern sich Mensch und Körper durch Technik und welches Menschenverständnis resultiert daraus für den TH? Als Ziele des TH markiert sie Perfektionierung, Kontrolle und Macht und ein Menschenbild, das zentral auf Information basiert. Dieses reduktionistische Menschenbild lasse den TH in die Nähe der Eugenik geraten und enthülle im TH prototalitäre Aspekte einer Ideologie, die sie mit dem Nationalsozialismus vergleicht. In scharfer Abgrenzung zum TH, aber in überraschend affirmativer Haltung zur technologischen Selbstoptimierung, entwickelt Puzio ihre Technikanthropologie mit Bezug auf den kritischen Posthumanismus und Donna Haraway.

Wie sieht Puzio das Verhältnis zur Religion: Im TH stechen zwar „religiöse Semantik und eine Fülle an religiösen Motiven“ hervor, etwa Unsterblichkeit, ewiges Leben, Heilsvorstellungen, die Beseitigung von Leid, die Möglichkeit eines entkörperlichten Daseins. Doch der Religion wird vom TH, der sich von ihr abgrenzen will, auch mangelnde Vernunft, Intoleranz und Unwissenschaftlichkeit vorgehalten (S. 54).

Die Ziele des TH verbergen sich teilweise hinter religiöser Motivik, von „gottähnlichen Fähigkeiten und himmlischen Zuständen“ reden und „paradiesische Klänge“ anschlagen, „auch wenn sich ihre Vorstellungen von denen der Religion sehr unterscheiden“ (S. 232). Anstelle einer unsterblichen Seele im Himmel trete bei einigen TH-Richtungen der „Upload“ des Geistes als Programmcode in den Computer, was Puzio als Gipfel einer Körperabwertung sieht. Der TH seinerseits bringe jedoch Körperabwertung mit Christentum und Platonismus in Verbindung, von denen er sich abzugrenzen sucht: „Die transhumanistische Sicht auf den Körper wird als harmlos abgetan, wenn Hughes sie z.B. mit Praktiken der ‚Abtötung des Fleisches‘ vergleicht: der ‚Selbstgeißelung im Katholizismus‘, der Selbstkastration in frühen griechischen und christlichen Sekten…“ (S. 258). Andere TH-Bestrebungen zielen dagegen auf die fleischliche Perfektionierung sexueller Lust zu ungekannter Ekstase transhumaner „superpersonen“: So „werde eine ’superperson‘ neue Geschlechtsorgane und mehr sexuelle Möglichkeiten mit sich bringen. Eine weibliche ’superperson‘ werde beispielsweise über mehrere Körperöffnungen verfügen“ (S. 260). Hier sieht Puzio „Vorstellungen von Männern für Männer“ und eine Instrumentalisierung des Körpers (S. 261). Aber letztlich konkretisiere sich das Menschenverständnis des TH als Anthropologie der Information, der eine metaphysische Essenz zugesprochen werde: „Die Information konstituiert im TH das Wesen des Menschen. In gnostischer Motivik soll der reine Geist vom stofflichen Körper befreit werden, der aber im TH nicht mehr Pneuma ist, sondern ‚pure Form‘, substratunabhängige Information“ (S. 266).

Ist der Transhumanismus totalitär oder neoliberal?

Die Ziele des TH sieht Puzio im Streben nach Perfektionierung, Kontrolle und Macht, die sich hinter Visionen einer „Steigerung des gegenwärtigen menschlichen Daseins“ (S. 231) verbergen. Der „Supermensch“ des TH, er könnte dem NS-Begriff vom „Übermenschen“ nahestehen? Mit der Frage: „Der Transhumanismus -eine Ideologie?“, folgt Puzio der Totalitarismus-Theorie Hannah Arendts und findet „protototalitäre Aspekte“ im TH: „Für den Nationalsozialismus bedeutet das beispielsweise, dass »nichts ›logischer‹ und konsequenter ist, als daß man […] parasitäre Rassen oder dekadente Völker eben auch wirklich zum Absterben bringt.« Der TH ist nicht in der Position, seine Visionen in Gesellschaft und Politik voll umzusetzen. Dennoch gilt auf diese Gefahr, auf die Arendt aufmerksam macht, auch hinsichtlich des TH wachsam zu bleiben. Denn denkt man die transhumanistischen Gedanken zu Ende und zieht daraus strikte Konsequenzen, dann gilt auch hier das Recht des Stärkeren, des ökonomisch Gewinnbringenden, des Produktiven oder der Maschine“ (S. 275f).

Diese Ideologie-Kritik am TH ist vielleicht etwas zu eng auf Arendts Totalitarismus-Theorie begrenzt, vergleicht den TH i.d.S. mit Stalinismus und vor allem der NS-Ideologie. Die heute nach Ansicht vieler Gesellschaftskritiker westliche Länder dominierende Ideologie ist aber der Neoliberalismus (vgl. z.B. Reimer 2023). Dieser formt maßgeblich Gesellschaft und Technologien eines Digitalen Kapitalismus, der tief in Alltag und Leben der Menschen hineinwirkt. Der Neoliberalismus wird leider nicht erwähnt, obwohl er starke Bezüge zu digitalen Technologien und Medien aufweist und mit dem TH u.a. Ziele der Optimierung, Kontrolle und Macht teilt.

Puzios engagierte Kritik am Transhumanismus und seinen teilweise überschießenden Visionen kontrastiert mit einer tendenziellen Kritiklosigkeit gegenüber heutiger Techniknutzung und Gesellschaft, so dass sich die Dissertation stellenweise fast wie ein Werbetext liest wenn Puzio schreibt: „Das neuste Model (Apple Watch 6) ermittelt sogar den Blutsauerstoffgehalt. Da sie den Schlafrhythmus erfasst und wasserfest ist, muss sie gar nicht mehr abgenommen werden. Mit der Apple Watch können Fitnessziele gesetzt und erreicht werden (…) Die Bewegungsaktivitäten lassen sich teilen, sodass man mit seinen Kontakten in einen Wettbewerb treten kann.“ (S. 306) Fraglich scheint, ob es sich dabei, wie Puzio meint, wirklich um autonomieförderliche „Technologien des Selbst“ handelt oder eher um eine (andernorts von ihr kritisierte) Kommerzialisierung des Körpers -die hier zudem mit einer neoliberalen Ideologie des Wettbewerbs unterlegt ist.

Puzio berichtet, wie vornehmlich junge Frauen heute eine Schönheits-OP unter Vorlage eines mit digitalen „Filtern“ aufgehübschten Selfies anstreben und wie auf Instagram Abmagerungswettbewerbe ein besonders knochiges Schlüsselbein belobigen. Doch auf die dort und in anderen „Social Media“-Plattformen epidemische Anorexie geht sie nicht ein. Kritikwürdig scheint ihr offenbar auch nicht, dass im Rahmen künftigen digitalen „social engineering“ Probleme wie „Finanzcrash, Klimaschutz oder revolutionäre Bewegungen“ unter Kontrolle gebracht werden sollen (S. 312). Dass hier Ökologie, Finanzregulierung und politische Unterdrückung technokratisch auf eine Stufe gestellt werden, scheint etwas problematisch. Doch soweit können wir Anna Puzio wohl ohne Probleme zustimmen: Der Transhumanismus folgt Zielen der Perfektionierung, Kontrolle und Macht und zeigt dabei zumindest bei einigen seiner Protagonisten ein reduktionistisches Menschenbild sowie prototalitäre Aspekte einer Ideologie -die aber auch Neoliberalismus heißen könnte.

Loh, Janina: Trans- und Posthumanismus zur Einführung, Hamburg: Junius 2018.

Anna Puzio: Über-Menschen. Philosophische Auseinandersetzung mit der Anthropologie des Transhumanismus. transcript (Bielefeld) 2022.

Jürgen-Michael Reimer: Der absurde Kapitalismus. Ein ideologiekritischer Essay. PapyRossa Verlag (Köln) 2023.