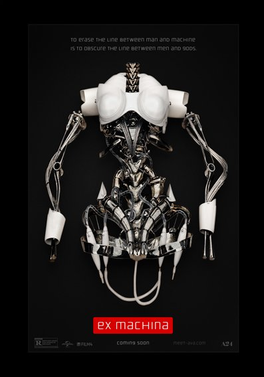

Ex Machina

Filmkritik von Thomas Barth

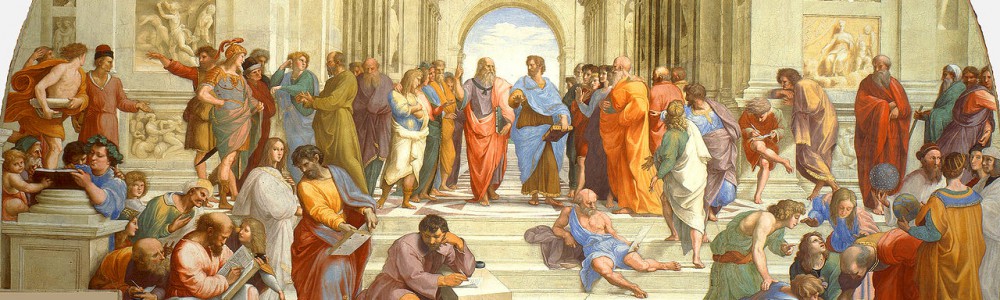

Aus der modernen Welt der hippen IT-Angestellten entführt uns Alex Garland (Buch und Regie) in einen stylischen Bunker, wo sich ein klaustrophobisches Dreiecksdrama mit Nerd und Cybergirl entfaltet. Der ästhetisch anspruchsvolle, subtile KI-Horror lädt zum Nachdenken ein. Doch die Reflexionen über KI bleiben letztlich eine Eulenspiegelei auf Weizenbaums frühe Kritik an der „künstlichen Intelligenzia“, weit entfernt etwa von Stanislaw Lem und seiner Futurologie der „Künstlichen Nichtintelligenz“.

Der junge Programmierer Caleb (Domhnall Gleeson) gewinnt einen Mitarbeiter-Wettbewerb in seiner hippen IT-Firma. Ein Hubschrauber bringt den Nerd in das einsam hoch im Norden gelegene Anwesen seines Chefs, des Computergenies Nathan (Oscar Isaac). Nathan stemmt Gewichte, besäuft sich abends mit edlen Tropfen und gibt den dominierenden Macho. Man glaubt ihm kaum den brillanten Suchmaschinen-Erfinder, der auf dem Gebiet der künstlichen Intelligenz forscht. Leider erfahren wir nur sehr wenig über seine gigantische Such- bzw. Überwachungsmaschine (Google lässt grüßen), im Film „BlueBook“ genannt –wohl eine Anspielung auf die gleichnamige Ufo-Sichtungsdatei der US-Behörden, die der frühe Computernetz-Kritiker und späteren UFO-Buchautor Jacques Vallee einst mit programmierte. Caleb lernt bald die betörende Gyndroidin Ava (Alicia Vikander) kennen, die er einem weiterentwickelten Turing-Test unterziehen soll. Mit durch eine Trennscheibe gestellten Fragen soll Caleb herausfinden, ob das Cybergirl über echte Gefühle verfügt, doch schnell verwickelt ihn Ava in ein spannungsgeladenes Beziehungsdreieck mit Nathan.

Alex Garland erwies sich schon mit dem Drehbuch zu Alles, was wir geben mussten als Meister des subtilen Horrors, wo er das Thema der Klon-Sklaverei um einiges anspruchsvoller inszenierte als die Popkornkino-Variante Die Insel es vermochte. Sein neuer Film Ex Machina bietet mehr an cineastischem Augenschmaus, der den Intellekt jedoch weniger befriedigt. Die elegante Kameraführung schafft in der minimalistischen Innenkulisse zwar eine kühle Atmosphäre, in der sich die Gyndroidin Ava mit ihrem erotischen, teils transparenten Körper entfalten kann.

Die Technologie interessiert Garland sichtlich weniger als menschliche Probleme und die Psychologie der Thematik, und so hoppelt die Handlung über einige logische Löcher: Man fragt sich, wieso für den Turing-Test von Ava ein Hightech-Gel-Computer in ihrem schönen Gyndroiden-Kopf überhaupt nötig ist. Ihre KI hätte man problemlos extern platzieren können. Fragwürdig sind jedoch auch Avas so immerhin erst möglich gemachten Fluchtpläne –sie übersehen Avas offenbar anspruchsvolle Energieversorgung. Was die echte Reflektion über Probleme der KI angeht, erreicht Ex Machina kaum das Niveau der skandinavischen SF-Serie „Hubots“, wenn auch auf ästhetisch anspruchsvollere Weise.

Digitale Kontrolle oder Voodoo-KI?

Alex Garlands Film regt zum Nachdenken an, aber leider nur sehr wenig über die Gefahren der gigantischen Überwachungsmaschine Google (bzw. „BlueBook“). Die globale Überwachung wird zwar ansatzweise kritisch erwähnt, aber da sie letztlich zur technologischen Basis von Avas KI erklärt wird, letztlich sogar glorifiziert. Zumindest für alle begeisterten Befürworter der KI-Konstruktion könnte das globale Netz von Google (oder womöglich sogar auch das der NSA) damit eine mystifizierende Rechtfertigung erfahren.

Hier klingen ferne Motive des klassischen Modells einer Noosphäre an, die sich moderner bei Cyber-Optimisten wie Pierre Levy in der „kollektiven Intelligenz“ der Netze finden. Levy gibt sich der Hoffnung hin, dass „die globale Totalität der Menschheit dabei ist, zum erstenmal zu einer einzigen kollektiven Intelligenz zu verschmelzen…“ (Levy S.247). Das „global brain, so to speak –the noosphere“ prägten das Genre des Cyperpunk schon in William Gibsons „Neuromancer“, wo es als mystische Voodoo-KI „Wintermute“ den Deus Ex Machina gab, so Erik Davis in „TechGnosis“ (Davis S.352). Das romantische Schwelgen in Träumereien von einer sich am Ende geheimnisvoll aus unserem technologischen Treiben erhebenden göttlichen KI ist verständlich, lenkt jedoch von konkreteren Problemen ab: Den neuen digitalen Kontrollregimen (Barth 1997) und der wachsenden Macht zur Manipulation von Mensch und Gesellschaft durch globale Medienkonzerne (Barth 2006).

Eulenspiegelei auf Weizenbaum

Und so bleibt auch das Nachdenken über die Künstliche Intelligenz bei Garland auf einem eher bescheidenen Niveau. Sein Film Ex Machina erscheint als Antwort auf die frühe Kritik an der frühen KI-Euphorie, wie sie sich bei Joseph Weizenbaum im „Künstliche Intelligenz“-Kapitel seines bahnbrechenden Klassikers „Die Macht der Computer und die Ohnmacht der Vernunft“ findet. Bestenfalls könnte man Ex Machina als Eulenspiegelei auf Weizenbaum sehen:„Da sich das menschliche Denken beispielsweise mit ästhetischen Problemen in Verbindung mit Fühlen, Schmecken, Sehen und Hören beschäftigt hat, wird AI Maschinen bauen müssen, die fühlen, schmecken, sehen und hören können.“ Weizenbaum, S.188 (vgl.S.276f.)

Hier setzt Garlands sexy Gyndroidin Ava an und sorgt mit ihren Gefühle reizenden weiblichen Kurven für Geschmacksverirrung, dass den KI-Forschern Hören und Sehen vergeht: Ava erweist sich als Sex-Roboter mit voll funktionsfähiger Vagina. Der künstliche Vamp hat Tradition im SF-Genre, schon seit Fritz Langs Metropolis. Und selbst der androide Star-Trek-Pinocchio Mr.Data, der die KI-Thematik schon in der spröden Enterprise-Serie durcharbeiten durfte, bekannte sich einmal –quasi hinter vorgehaltener Hand- zu seinem einsatzbereiten Penis. Ex Machina stellt den Maschinen-Eros ins Zentrum, macht ihn zum Prüfstein im (vorgeblichen) Turing-Test. Aber kann die Thematik vom Robot und seinen Gefühlen heute wirklich noch zu Reflexionen über die Probleme der KI anregen?

Weizenbaums auf menschliche Körperlichkeit und Emotionen abzielende Argumentation richtete sich damals nur an die ersten Frühformen, quasi die Neandertaler der KI-Forschung, wie z.B. Newell & Simon. Die glaubten mit ihrem „General Problem Solver“ (GPS) schon den menschlichen Geist nachzubilden, obgleich der es nur bis zum mäßigen Schachspielen brachte. Sie waren sich immerhin noch bewusst, eine reduzierte Sicht des Menschen zu vertreten, den „homo cogitans“ (Newell & Simon S.113) –daher spricht man von kognitivistischer KI-Forschung, die aber später vom Konnektionismus mit seinen Neuronalen Netzen überflügelt wurde.

Die frühen KI-Euphoriker, die Weizenbaum als extreme „künstliche Intelligenzia“ bezeichnete (Weizenbaum S.282), wollten damals menschliches Schlussfolgern in Algorithmen nachbilden. Sie wollten allen Ernstes schon alsbald z.B. menschliche Richter durch Computer ersetzen, so bekannte ein hierzulande eher unbekannter KI-Extremist namens John McCarthy (Weizenbaum S.275). McCarthy glaubte, es sei nützlich, Computern menschliche Eigenschaften zuzuschreiben, wenn dies dabei helfen würde, sie zu reparieren oder zu verbessern. Dies mag für Ingenieure gültig sein, wird aber problematisch, wenn es zu einer neuen „Ansicht über den menschlichen Geist“ verallgemeinert wird (McCarthy S.221).

Künstliche Nichtintelligenz

Der Rechtsinformatiker Wilhelm Steinmüller, der Informationssysteme auch als „Machtfabriken“ (S.530) sieht, urteilt in seinem Opus Magnum „Informationstechnologie und Gesellschaft“ weniger optimistisch:

„Bei echten KI-Systemen treten in gewissem Umfang an die Stelle determinierter Verfahren stochastische Verfahren. Sie entscheiden –wenn auch eingeschränkt- nach dem Zufall… Doch ist es weder mit der Ethik der Informatik noch mit unserer Rechtsordnung vereinbar, Zufall –wenn auch eingeschränkt- über physische oder soziale Existenz von Menschen oder Institutionen bestimmen zu lassen. Darum ist die wichtigste Anforderung des Informationsschutzes ihr Verbot, wo sie über Leben oder soziale Chancen befinden.“ Steinmüller, S.693

Diesen Rat hätten die Akteure in Garlands Film Ex Machina besser beherzigen sollen –oder sich fragen, warum Alan Turing seinem epochemachenden Aufsatz „Kann eine Maschine denken?“ (1950) ein Zitat von Shakespeare voranstellte: „Der Spaß ist, wenn mit seinem eignen Pulver der Feuerwerker auffliegt…“, Hamlet. So geht der gyndroide Sexroboter Ava seinen von Frankenstein bis Blade Runner vorhersehbaren Weg, ohne uns allzu viel Anregung zu ernsthaftem Nachdenken über aktuelle KI-Forschung geliefert zu haben. Die naiven Antworten auf die Kritik an quasi prähistorischen KI-Systemen greifen wenig, die rudimentären Verweise auf Noosphäre und kollektive Intelligenz im Netz hätten weiter verfolgt werden können.

Stanislaw Lem sprach in seinem Buch „Die Technologiefalle“ von „Künstlicher Nichtintelligenz“ (S.141), die womöglich bei gezielter Informationszüchtung entstehen könne, kaum aber einfach so im Internet. Der späte KI-Extremist Marvin Minksy schien mit seiner „Mentopolis“ zwar eine Brücke vom globalen Netz der „Telepolis“ zu solcher Datenzüchtung schlagen zu wollen. Doch dies blieb rudimentär und Minsky verstrickte sich eher in ähnliche Fragen wie Garland, ob und wie einer KI nicht erst Gefühl einprogrammiert werden müsse (Minsky S.163). Von der Schaffung einer echten KI, die den menschlichen Geist auch nur annähernd nachbilden oder zu ihm ähnlichen Ergebnissen kommen könnte, bleiben solche Ansätze noch weit entfernt.

„Die Entwicklung der KI muß mit der Entwicklung des biologischen Zentralnervensystems nicht äquifinal sein. Die Möglichkeiten sind so weit wie der Ozean, und wir haben weder einen ordentlichen Kompaß noch eine Karte.“ Stanislaw Lem, S.261 (zuerst auf filmverliebt)